Le temps réel s’invite au cinéma

Les effets visuels au cinéma

De plus en plus de films aujourd’hui se servent de logiciels d’effets visuels (2D/3D), que ce soit pour des films entièrement produits en animation numérique ou encore pour la création d’effets visuels dans des films en tous genres.

La création de ces effets dépend bien sûr du travail de différentes équipes d’artistes 2D et 3D qui ont toute leur expertise propre (modelling, textures, éclairage, surface, animation, simulation de particules, eau feu fumée, cheveux, foules, composition d’image, etc.) Les studios de VFX sont amenés à développer des outils et des méthodes de travail sur mesure pour chercher à décloisonner les différents départements et favoriser autant que possible la transversalité. Ce travail nécessite aussi beaucoup de temps et de ressources humaines et informatiques1, ce qui coûte très cher et ne permet pas aux cinéastes de voir les images de leur film rapidement après le tournage.

Pour pallier cette lourdeur, le monde du cinéma est mis au défi par un médium plus jeune: le jeu vidéo. En effet, la division des étapes de production et de post-production pourrait changer considérablement les méthodes de travail grâce aux moteurs de rendu en temps réel utilisés en jeu vidéo. En effet, la puissance de ces engins de calcul en temps réel permet de mettre en scène des images virtuelles dès le début de tournage, permettant d’évaluer leur intégration avec les images filmées. Déjà en 2013, Kim Libreri (de Lucasfilm à l’époque) s’imaginait un futur où les moteurs de jeu en temps réel permettraient d’impliquer les effets visuels dès le début d’un tournage2. Ce futur paraît plus proche de jour en jour quand on regarde ce que permettent de faire des moteurs tels Unreal Engine (utilisé lors du tournage de la série The Mandalorian (2019- )) ou Unity (utilisé pour la production du Roi Lion (2019)).3 Quels sont donc les avantages d’un moteur de jeu par rapport aux outils traditionnellement utilisés pour créer les effets visuels d’un film ?

Temps réel

L’un des avantages principaux des moteurs de jeu modernes est la vitesse du rendu. Comme le suggère l’appellation « temps réel », un moteur de jeu est conçu pour produire des images (calculer l’image et l’afficher) en millisecondes, une cadence beaucoup plus élevée que les logiciels d’effets visuels utilisés au cinéma qui nécessitent parfois plusieurs heures, voire des jours, pour calculer une image en haute qualité. Les moteurs de jeux vidéo permettent de restituer des images en temps réel malgré les différentes actions du joueur ou du réalisateur et de s’adapter instantanément aux itérations créatives. Qui plus est, cette rapidité permet une qualité du rendu final impressionnante. Comme l’explique Noah Kadner dans le dernier numéro d’American Cinematographer, « les moteurs de jeu étaient initialement optimisés pour la vitesse plutôt que la qualité de l’image […]. Ces dernières années, des innovations techniques majeures au niveau des processeurs graphiques des ordinateurs ont permis à ces moteurs de produire des images dignes d’une production cinématographique, tout en maintenant leur vitesse en temps réel ».4

Auteur du Virtual production field guide d’Epic Games (la compagnie derrière Unreal Engine), Kadner y donne comme exemple deux fonctions qui permettent aux moteurs de jeu de produire des images de haute qualité en temps réel : le niveau de détail (ou LOD pour Level of detail) et la décimation.5 Pour accélérer le rendu des calculs et arriver à une vitesse digne du temps réel, les moteurs de jeu font appel à plusieurs stratégies d’optimisation. Le contrôle du « LOD » implique l’ajustement dynamique du niveau de détail d’un élément graphique (décor, personnage, effet quelconque), par exemple en fonction de sa position par rapport à la caméra (une densité visuelle diminuée pour des objets plus lointains et donc plus petits). La fonction de « décimation », pour sa part, vise à réduire la densité d’un modèle 3D tout en maintenant la qualité visuelle, ce qui permet d’alléger la charge de calcul et d’assurer un rendu en temps réel.6

Une autre fonction d’un moteur de jeu qui en fait un outil pertinent pour une production cinématographique est sa capacité à simuler de manière naturelle le comportement de différentes sources de lumière de sorte à produire des images encore plus photoréalistes. Autrefois, il fallait des raccourcis pour simuler l’apparence de la lumière dans une scène (par exemple, via des textures de lumière (lightmap)), mais aujourd’hui, les fonctions d’illumination globale et le ray tracing (tracé des rayons de lumière) sont intégrées aux moteurs de jeu et sont calculées en temps réel au niveau des processeurs graphiques (notamment la gamme de processeurs RTX de la firme Nvidia, depuis 2018). Dans une vidéo au sujet de son travail avec Unreal Engine et de son choix de carte graphique, le directeur photo et développeur Matt Workman explique que le tracé des rayons de lumière est une fonction essentielle pour l’industrie du cinéma qui recherche d’abord et avant tout le réalisme.7 C’est ce qui lui permet, entre autres choses, de placer une source de lumière au sein d’un environnement virtuel et de la travailler tout comme il le ferait lors d’un tournage (lumière clé, lumière d’appoint, boîte à lumière, réflecteur, tungstène, DEL, température, etc.).

Vers un langage commun

Ce que Workman souligne quand il évoque l’avantage de pouvoir placer une source de lumière tel qu’il le ferait sur un plateau de tournage, c’est le brouillement des frontières entre les méthodes de tournage en prise de vues réelles et les capacités d’outils plus typiquement associés à la post-production ou au jeu vidéo. On peut utiliser un moteur comme Unity ou Unreal Engine sans abandonner le langage et les concepts propres aux techniques cinématographiques. C’est ce qui permet à des cinéastes d’expérience d’adopter ces outils sans devoir écarter toutes leurs connaissances. Casey Schatz, du studio The Third Floor, insiste lui aussi sur l’accessibilité des moteurs de jeu pour des cinéastes traditionnels : « L’objectif a toujours été que même quelqu’un qui n’a jamais touché un ordinateur de sa vie, mais qui est un directeur photo remarquable, pourrait s’asseoir avec un artiste numérique et lui parler dans un langage auquel il est habitué — f-stop, T-stop, vitesse d’obturation, ISO, grain, lumière réfléchie, lumière diffuse — les termes cinématographiques traditionnels qui existent depuis plus de cent ans ».8

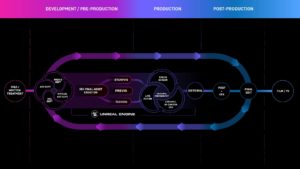

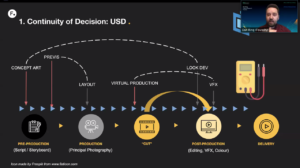

Sans devoir abandonner les techniques cinématographiques traditionnelles, le mode de production est tout de même profondément transformé. La dynamique habituelle entre la pré-production, la production et la post-production s’en voit bouleversée, de sorte que ce qui était typiquement réservé à l’étape de la post-production peut maintenant se faire en grande partie au moment du tournage.

Graham Edwards, dans un billet de blogue pour la revue spécialisée Cinefex datant de 2013, évoque à cet effet qu’on semble revenir à la manière dont les effets visuels étaient traditionnellement produits, bien avant les outils numériques : avec des maquettes, la peinture sur cache, la perspective forcée, la projection arrière, etc. « Il était une fois », écrit-il « tout était fait à même la caméra. Dans le futur, il semblerait que ce le sera de nouveau ».9

Kadner lui-même insiste sur le maillage qui peut ainsi se produire entre les différents départements qui étaient auparavant cloisonnés : les effets visuels qui auraient typiquement été produits lors de la post-production au fil de plusieurs heures de rendu peuvent maintenant être présentés en temps réel au moment du tournage. Cela permet à tous de s’entendre sur une vision commune et de connaître déjà lors de la production le résultat de son travail.10 De cette manière, il est aussi plus facile d’unifier la chaîne de travail et d’assurer une certaine homogénéité au projet en utilisant les mêmes données du début à la fin.

Itération

Cette capacité à représenter en temps réel les images (quasi) finales du film est d’autant plus pratique qu’elle permet aux cinéastes d’expérimenter plus librement. Dès le moment de la pré-production, les moteurs de jeu permettent de créer des décors numériques afin de mieux visualiser une scène, ou bien pour concevoir les décors qui devront être construits; c’est le processus qu’on appelle la prévisualisation. On peut ainsi procéder à un repérage virtuel en explorant des décors ou des environnements assemblés dans un moteur de jeu sans devoir se déplacer ou construire des décors réels. Il est même possible d’utiliser un casque de réalité virtuelle et ainsi naviguer l’espace soi-même afin de voir de ses propres yeux ce dont son film aura l’air, et ce, avant même d’avoir débuté l’étape de la production, à proprement parler. C’est grâce à ce genre de prévisualisation que l’équipe du studio Painting Practice s’est servie d’Unreal Engine pour modéliser les décors de la série His dark materials (2019- ). Joel Collins, producteur exécutif et concepteur de production pour la série, affirme ainsi que les outils de prévisualisation ont permis de concevoir les décors en amont et ainsi d’éviter des pertes de temps et des surplus budgétaires.11 Zach Alexander, fondateur du studio Lux Machina, va dans le même sens quand il explique que l’un des plus grands bénéfices de la prévisualisation est le temps que l’on arrive à sauver : « Chaque heure de pré-production en vaut deux en production ».12

Grâce aux moteurs en temps réel et la (pré)visualisation qu’ils permettent, il est plus facile d’essayer différentes possibilités avant et pendant le tournage et ainsi éviter de ne remarquer un problème que bien plus tard lors de la post-production. Comme l’explique Kadner dans son Virtual production field guide, « L’itération est l’action d’améliorer un processus au fil de tentatives successives afin d’arriver au résultat voulu. […]13 Créer des images à des fins de prévisualisation via des moteurs de jeu en temps réel débloque d’autres bienfaits. Les séquences peuvent être mises à jour plus rapidement et représentées à des niveaux de qualité élevés. Ainsi, plus de membres de l’équipe arrivent à partager une vision du contenu final beaucoup plus tôt lors de la production ».14 Rappelons également que les données créées pour la pré-production peuvent être réutilisées lors de la production et qu’elles pourront servir au rendu final lors de la postproduction. Dan Ring, Chef de la recherche chez Foundry (la firme derrière Nuke) explique à cet effet que la conformité des données le long du processus créatif est l’un des facteurs clés de cette transition vers les modes de production virtuelle en temps réel.

Place à l’erreur

Lors de sa présentation dans le cadre de l’événement RealTime Conference en avril 2020, Dan Ring, soulignait également que l’un des avantages des modes de production virtuelle est la liberté de faire des erreurs dès le début d’une production : « fail early, fail often ».16 Cela revient à dire que la visualisation permise par un moteur en temps réel donne aux cinéastes le pouvoir de régler ces problèmes en amont plutôt que tout laisser pour la fin du projet. C’est également ce qu’explique Kadner lorsqu’il écrit que les « décisions créatives au sujet des images et des séquences peuvent être réglées beaucoup plus tôt lors de la production, alors que toute l’équipe est présente, plutôt que d’être laissées à la dernière minute lors de la post-production quand les équipes se sont dissoutes depuis longtemps ».17 L’auteur explique ainsi que « l’adoption des modes de production virtuelle peut changer l’attitude de toute une équipe de « réglons ça en post[-production] » à « réglons ça en pré[-production] » et « réglons ça en production »18.

Place à l’intuition créative

Un autre avantage de la rapidité des moteurs en temps réel est la possibilité de réagir instinctivement à la scène alors qu’elle se déroule. C’est un aspect sur lequel insiste souvent Rob Legato, superviseur des effets spéciaux sur des productions telles Avatar (2009), Le livre de la jungle (2016) et Le roi lion (2019). Plus particulièrement, Legato critique la lenteur des logiciels d’animation numérique traditionnels qui laisse trop de temps à la réflexion, ce qui mène selon lui à des images trop intellectuelles. En se servant des moteurs en temps réel, explique-t-il : « Ce que nous essayons de faire c’est exploiter vos réactions instinctives, vos décisions artistiques instantanées ».19

Lors du tournage du Roi lion, par exemple, les outils de production virtuelle construits par la firme Magnopus à partir de l’infrastructure du logiciel Unity ont permis au directeur photo, Caleb Deschanel, de tourner les scènes avec le même temps de réaction que sur un tournage en prise de vues réelles.

Ben Grossman, superviseur de la production virtuelle chez Magnopus, explique à cet effet que deux moniteurs étaient placés devant Deschanel, l’un présentant des images d’une qualité phénoménale à une cadence réduite (environ 20 images secondes) afin de juger l’éclairage, et l’autre à une cadence dépassant les 120 images par seconde pour lui permettre de mieux réagir au déroulement de la scène.20 Dans leurs descriptions des outils développés pour le tournage du Roi lion, Grossman et Legato insistent d’abord et avant tout sur l’importance de laisser place à l’inventivité humaine. Autrement dit, le but n’est pas de tout virtualiser et d’abandonner les techniques cinématographiques traditionnelles, mais bien de valoriser ce qui est le plus important dans la production d’un film : l’humain derrière la caméra et l’histoire que ces outils permettent de raconter.

The Mandalorian

L’une des innovations les plus fascinantes permises par les moteurs en temps réel est démontrée par The Mandalorian. En effet, près de la moitié du tournage de la série créée par Jon Favreau (Le livre de la jungle (2016), Le roi lion (2019)) s’est déroulé sur un plateau entouré à 270° par une série d’écrans DEL de plus de six mètres de haut. Ces murs et ce plafond d’écrans avaient deux fonctions principales. Dans un premier temps, en tant qu’extensions de décors, ils permettaient aux personnages d’être entourés par des environnements complexes dotés de profondeur. Ces décors étaient rendus en temps réel, permettant aux interprètes de connaître leur environnement, ce qu’il leur aurait été impossible de faire devant un écran vert.

Puisque ces décors proviennent d’un moteur de jeu (en l’occurrence Unreal Engine), les cinéastes peuvent déplacer l’environnement en entier comme bon leur semble, ce qui facilite le changement de décor : on peut passer d’un intérieur à un extérieur instantanément, ou bien tout déplacer de quelques mètres dans la direction voulue sans que l’équipe technique (machinistes, éclairagistes, etc.) n’ait à refaire la mise en place. De plus, comme l’environnement peut s’adapter en temps réel, il est possible de modifier le décor en fonction des mouvements de la caméra. Cela permet de créer des espaces d’une profondeur infinie puisque la perspective est toujours construite correctement en fonction de la position de l’appareil de prise de vues. Qui plus est, la caméra capte directement les performances des interprètes, les éléments de décor réels, ainsi que les environnements numériques sans qu’il y ait besoin de créer une image composite par la suite : tout est filmé à même la caméra.

Dans un second temps, puisque ces écrans DEL émettent leur propre lumière, il est possible de modifier l’apparence d’une scène à la volée. Les cinéastes peuvent choisir de passer d’un soleil levant à un ciel ennuagé en un simple clic, ou encore de générer toute une série d’effets de couleurs, à la fois possibles ou impossibles. C’est ainsi que l’effet d’hyperespace a pu être capté à même la caméra (dans l’épisode 6 de la série, notamment, mais aussi dans le film Solo: Une histoire de Star Wars (2018)). Qui plus est, cette lumière tombe naturellement sur les interprètes et les éléments de décors réels, ce qui crée de vraies ombres et de vrais reflets, captés directement par la caméra. En parlant de StageCraft, le système de production virtuelle mis en place par Industrial Light & Magic, Rob Bredow expliquait : « C’était réellement un rêve devenu réalité que de voir nos décors numériques être pleinement intégrés, en temps réel, sur le plateau, produisant le genre d’images à même la caméra dont nous avons toujours rêvé, et ce, tout en fournissant la majorité de l’éclairage ».21

Telle est la voie

La production de la série The Mandalorian est particulièrement impressionnante et nous donne à voir plusieurs aspects de cet ensemble de transformations des modes de production cinématographiques qu’on réunit sous la bannière de « production virtuelle ». Les exigences techniques de ces productions à grands budgets ne devraient pourtant pas faire peur à celles et ceux qui souhaiteraient s’initier, à petite échelle, à la production virtuelle et aux différentes possibilités ouvertes par les moteurs de jeu en temps réel.

Il faut considérer qu’Unreal Engine et Unity peuvent être téléchargés gratuitement sur les sites Web des compagnies qui les ont conçus. Peu importe sa plateforme de prédilection (Mac ou Windows), quiconque peut donc installer ces logiciels et se lancer dans l’utilisation d’outils de production virtuelle qui sont essentiellement les mêmes qu’utilise Hollywood. Qui plus est, Internet regorge de ressources qui visent à faciliter l’apprentissage des solutions de (pré)visualisation en temps réel. Matt Workman en est un parfait exemple avec sa chaîne YouTube Cinematography Database qui fait office de journal de bord alors qu’il apprivoise les outils de production virtuelle et développe de nouvelles stratégies pour produire des films avec Unreal Engine, le tout en tant que cinéaste indépendant. Par exemple, depuis février 2020, Workman montre comment un système de réalité virtuelle accessible au grand public (en l’occurrence, le HTC Vive) peut servir à contrôler une caméra virtuelle dans Unreal Engine. Ce faisant, il arrive à « filmer » des scènes en temps réel tout comme l’a fait l’équipe derrière Le roi lion.22 Workman gère également une page Facebook, nommée « Unreal Engine : Virtual Production », qui regroupe des individus qui cherchent à produire des œuvres cinématographiques à l’aide d’outils en temps réel.23 La communauté y est très accueillante et permet d’apprendre beaucoup de nouvelles façons de travailler.

La quantité de ressources disponibles pour apprendre les outils de production virtuelle peut paraître intimidante. Dans ce cas, il peut être plus judicieux de se tourner vers les formations spécialisées sur les moteurs en temps réel.

Bien sûr, les outils évoluent constamment et on ne cesse d’inventer de nouvelles manières de travailler. Il faudra donc que les formations traditionnellement orientées vers la production de films ou le développement de jeu vidéo ajoutent à leur cursus un nouveau paradigme; celui de la production virtuelle en temps réel. Les tendances du secteur des effets visuels et du jeu vidéo assument de plus en plus leur convergence technique, aujourd’hui on assiste aux balbutiements d’une connivence créative très prometteuse.

Notes et références

1 Par exemple, un film comme Big Hero 6 de Disney (2014) a été rendu par une série de centres de calculs et aura nécessité 199 millions d’heures de calcul (l’équivalent de 180 jours) pour le rendu final. Voir Lamelot, Matthieu. 2014. « 55 000 coeurs pour illuminer Big Hero 6 de Disney ». Tom’s Hardware. (consulté le 4 mai 2020). https://www.tomshardware.fr/55-000-coeurs-pour-illuminer-big-hero-6-de-disney/ et Bielik, Alain. 2015. « Les Nouveaux Héros ». Pixelcreation.fr (consulté le 4 mai 2020) https://www.pixelcreation.fr/3d-video/animation-3d-vfx/les-nouveaux-heros/

2 Edwards, Graham. 2013. « We’ll fix it in pre-production ». Cinefex (consulté le 22 avril 2020). https://cinefex.com/blog/well-fix-it-in-pre-production/

3 Kim Libreri travaille maintenant comme CTO (Chief Technology Officer) chez Epic Games, les fabricants du moteur Unreal

4 Engine. « By contrast, game engines were initially optimized for speed first and image quality second, in order to support gameplay in real-time, often at frame rates of 60 frames per second or more. And in the past few years, major technical advancements in the graphics-processing unit (GPU) of computers have enabled such engines to render production-quality imagery while maintaining their real-time speed ». Kadner, « Game on », 68.

5 « Level of detail (LOD) control and decimation of assets is built directly into the engine to enable the same high-quality source asset to be decimated enough to work in real time at the desired frame rate, while still preserving the visual fidelity ». Kadner, Noah. 2019. Virtual production field guide. Epic Games, 21.

6 Notons que la décimation n’est pas limitée aux moteurs de jeu. L’outil Polygon Cruncher de la firme française Moo Tools est offert comme module d’extension pour les logiciels Maya et 3ds Max. https://www.mootools.com/fr/logiciel/polygon-cruncher

7 « But the thing I’m mostly interested in is using the RT cores […] that allow me to ray-trace light. Ray tracing has gone through a couple different iterations of how it’s being marketed, but just know that for the film industry, for pro-vis, for visualisation, we are the drivers who need ray-tracing. We want realism, we don’t want to do as many video game trick lighting things if we don’t have to. We want to approach it from a physical, realistic lighting point of view. » Cinematography Database [Matt Workman]. 2020. « WHY I use the Nvidia QUADRO RTX 8000 ». Publiée le 24 avril. https://youtu.be/l7iYiq0zYiE

8 « The goal has always been that even someone that has never touched a computer before, but is a remarkable cinematographer, can sit down next to a computer artist and talk in the language that they’re comfortable with — f-stops, T-stops, shutter speeds, film ISOs, grain, bounce light, diffuse light — the traditional cinematography terms that have existed for more than 100 years. » Kadner, « Game on », 75.

9 « Back in the earliest days of cinema, a matte artist would set up a big sheet of glass in front of the camera and paint the background right before the director’s eyes. Hanging miniatures – the original set extensions – were modelled in the workshop and mounted on rigs just inches from the lens. In both cases, when the director looked through his viewfinder, he saw the finished shot. Once upon a time, everything was done in camera. In the future, it looks like it will be again. » Edwards, « We’ll fix it in pre-production ».

10 « Creating previs imagery via a real-time engine unlocks additional benefits. Sequences can be quickly updated and output at very high levels of image quality. As a result, more members of the team can share the vision of the final content much earlier in production. » Kadner, Virtual production field guide, 7.

11 « “These are very expensive sets, and on a show like His Dark Materials, where you’re building an entire town for one episode, you’ve got to make really good decisions that are practical and financial and creative, and they’re all combined,” [Joel Collins] says. “What Painting Practice’s team created gave us an ability to make critical judgments that meant that we could get it right on the edge of affordable and absolutely on the edge of shootable, in the sense of there was no fat on what we built.” » Lumsden, Ben. 2020. « Designing sets and action sequences on His Dark Materials with virtual production ». Unreal Engine (consulté le 22 avril 2020). https://www.unrealengine.com/en-US/spotlights/designing-sets-and-action-sequences-on-his-dark-materials-with-virtual-production

12 « Zach Alexander, Founder and COO of Lux Machina, notes the practical benefits of virtual production previsualization techniques with his statement, “Every hour of pre-production is worth two hours of production.” » Cité dans Kadner, Virtual production, 4.

13 « Iteration is the act of refining a process over successive attempts to arrive at a desired result. All too often, the iteration process in traditional production is wasted on finding a common starting point instead of refining an agreed-upon shared vision. » Kadner, Virtual production, 5.

14 « Creating previs imagery via a real-time engine unlocks additional benefits. Sequences can be quickly updated and output at very high levels of image quality. As a result, more members of the team can share the vision of the final content much earlier in production. »

15 Ring, Dan. 2020. « Bridging the real & imagined: Integrating real-time workflows into modern visual-effects and post-production pipelines ». RealTime Conference, 6-7 avril 2020. En ligne.

16 Idem.

17 « Creative decisions about shots and sequences can be resolved much earlier in production, when the entire team is present, and not left to the last minute of post-production when crews have long since disbanded. » Kader, Virtual production, 7.

18 « Indeed, the embrace of virtual production can shift the entire crew’s mindset from “fix it in post” to “fix it in pre” and “fix it in production.” » Kadner, Virtual production, p. 22.

19 « In a CG production, you’re not seeing something in real time, you’re not reacting in real time, and you have too much time to think about it, so everything becomes more intellectual, and what we’re trying to do is tap into your gut-level response to things, your instantaneous art choice ». Rob Legato dans « The Lion King: Breaking ground with virtual production ». Le roi lion, 2019. Blu-Ray. Disney 2019.

20 « We set up two monitors next to Caleb [Deschanel] (DoP). One was the monitor he used to operate (running at 120+fps), and the other was the monitor that he used to judge lighting ». Ben Grossman, cité dans Seymore, Mike. 2019. « How Virtual Production Worked On-set of the Lion King ». Fxguide (consulté le 4 mai 2020). https://www.fxguide.com/fxfeatured/how-virtual-production-worked-on-set-of-the-lion-king/

21 « StageCraft has grown out of the culmination of over a decade of innovation in the virtual production space at ILM. Seeing our digital sets fully integrated, in real-time on stage providing the kind of in-camera shots we’ve always dreamed of while also providing the majority of the lighting was really a dream come true. » Rob Bredow, cité dans Seymore, Mike. 2020. « Art of LED wall virtual production, part one: “Lessons from The Mandalorian” ». Fxguide (consulté le 4 mai 2020). https://www.fxguide.com/fxfeatured/art-of-led-wall-virtual-production-part-one-lessons-from-the-mandalorian/

22 Cinematography Database [Matt Workman]. 2020. « Testing the Vive Tracker + UE4 Virtual Camera » Publiée le 1er mars 2020. https://youtu.be/M2qhJbBEsiY

23 Ailleurs, Matt Workman explique que la plupart des cinéastes peut apprivoiser les outils de prévisualisation: « Most cinematographers who are on the technical side pick up [game engine powered previsualization] very quickly. If you want to add light coming through the window, the steps to get there are very quick. It’s the same way you do it in the real world. » Cité dans Kadner, « Game on », 68.